Panduan Dasar Robots.txt (Sintaksis, Aturan, & Kegunaan)

Hai DomaiNesians! Kali ini kita akan membahas panduan dasar robots.txt yang mencakup sintaksis, aturan, serta kegunaannya. Banyak pemilik website yang ingin mengontrol cara crawler mesin pencari mengakses situs mereka sering kali membutuhkan pemahaman mendalam tentang dasar robots.txt. Panduan ini hadir untuk memberikan solusi lengkap terhadap kebutuhan tersebut, sehingga kita bisa mengoptimalkan pengelolaan akses bot dengan lebih baik.

Mengenal Singkat Robots.txt

Robots.txt merupakan file teks sederhana yang ditempatkan di root directory website. File ini berfungsi sebagai protokol pengecualian robot yang memberi instruksi kepada crawler mesin pencari tentang bagian mana dari situs yang boleh atau tidak boleh diakses. Dengan adanya dasar robots.txt, kita bisa mengarahkan bot untuk tidak mengindeks halaman tertentu yang tidak diinginkan.

Pentingnya dasar robots.txt terletak pada kemampuannya untuk menjaga performa server tetap stabil. Tanpa pengaturan yang tepat, crawler bisa membebani situs dengan permintaan berlebih, sehingga memperlambat loading bagi pengunjung manusia. Selain itu, dasar robots.txt membantu mencegah pengindeksan konten duplikat atau pribadi yang bisa merugikan visibilitas situs.

Keterkaitan dasar robots.txt dengan SEO sangat erat karena file ini memengaruhi cara mesin pencari seperti Google atau Bing mengcrawl dan mengindeks konten. Pengaturan yang salah bisa menyebabkan halaman penting tidak terindeks, sementara yang benar justru meningkatkan efisiensi crawling dan ranking.

Beberapa kegunaan utama dari dasar robots.txt antara lain:

- Memblokir akses bot ke folder admin atau file sensitif

- Mengizinkan crawling hanya pada bagian tertentu situs

- Mengarahkan bot ke sitemap untuk crawling lebih efisien

- Mencegah overload server dari crawler agresif

- Mendukung privasi dengan menyembunyikan halaman login atau draft

Untuk mengetahui lebih banyak terkait pengertian dasar robots.txt, kita bisa membaca artikel lengkap di DomaiNesia pada link berikut https://www.domainesia.com/berita/robots-txt-adalah/.

Struktur Konfigurasi Robots.txt

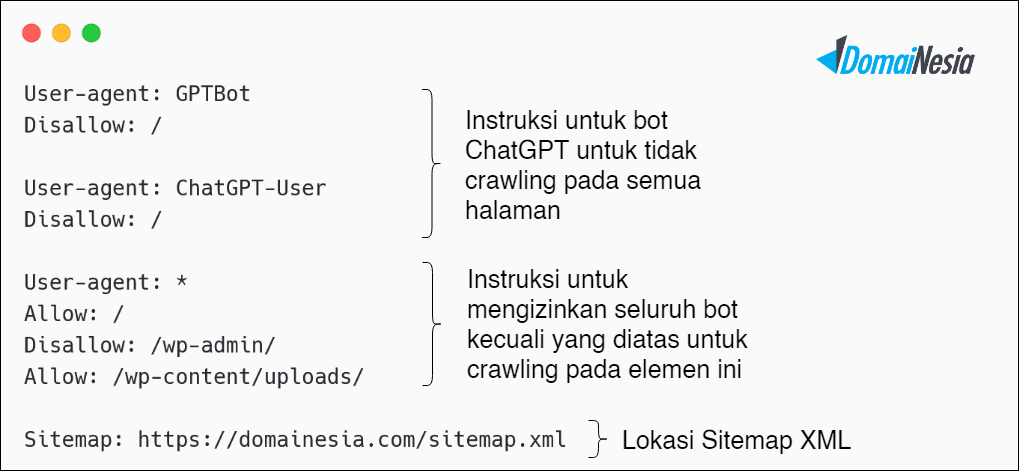

Nah, DomaiNesians, dasar robots.txt pada umumnya akan terlihat seperti aturan yang berstruktur dengan direktif-direktif sederhana yang disusun secara berurutan. Struktur ini memungkinkan kita untuk menentukan user-agent mana yang terpengaruh dan tindakan apa yang harus dilakukan terhadap URL tertentu.

Struktur di atas tidak memiliki urutan tetap yang harus diikuti secara ketat. Kita bebas menukar posisi grup direktif atau menambahkan sesuai kebutuhan situs nantinya, selama tetap mengikuti dasar robots.txt yang standar agar crawler bisa membacanya dengan benar.

Aturan Dasar Yang Perlu Diperhatikan

Dasar robots.txt memiliki beberapa aturan penting yang perlu diperhatikan agar konfigurasi dapat berjalan sesuai dengan format yang digunakan oleh sebagian besar crawler. Mengabaikan aturan ini bisa menyebabkan instruksi tidak terbaca atau malah memberikan efek yang tidak diinginkan pada crawling situs.

Penamaan File dan Format UTF-8

File harus bernama tepat “robots.txt” dengan huruf kecil semua. Penamaan dengan huruf besar atau variasi lain seperti “Robots.TXT” bisa membuat crawler tidak menemukannya. Selain itu, format penulisan file menggunakan UTF-8 tanpa BOM untuk memastikan kompatibilitas lintas platform dan menghindari error parsing pada dasar robots.txt.

Direktif Harus Jelas

Direktif dalam dasar robots.txt harus jelas dan tidak boleh ada redundansi dari URL yang ditargetkan. Contoh direktif yang kurang spesifik:

|

1 2 |

User-agent: * Disallow: /file |

Direktif tersebut akan memblokir akses bot ke semua URL seperti /file, /file/, /file-1, hingga /file.php. Akibatnya, kita perlu lebih spesifik dengan menyebutkan keseluruhan path URL atau file yang benar-benar ingin diblokir pada website agar tidak memengaruhi konten lain secara tidak sengaja.

Baris Baru Untuk Setiap Direktif

Setiap direktif dalam dasar robots.txt harus ditempatkan pada baris baru agar fungsinya bekerja dengan benar. Contoh yang salah:

|

1 |

User-agent: * Disallow: /file-1/ Allow: /file-2/ |

Pada contoh tersebut, jika kita ingin memblokir /file-1/, folder itu tetap bisa diakses bot karena perintah Allow pada baris yang sama mengoverride blokir. Untuk membuat blokir tetap efektif, ubah menjadi format dengan baris terpisah:

|

1 2 3 |

User-agent: * Disallow: /file-1/ Allow: /file-2/ |

Dengan cara ini, setiap instruksi diproses secara independen sesuai dasar robots.txt.

Memakai Simbol Wildcard

Simbol wildcard (*) pada dasar robots.txt berfungsi untuk mencocokkan pola arbitrary character dalam user-agent atau URL. Contoh penggunaan:

|

1 2 |

User-agent: * Disallow: *? |

Simbol wildcard pada contoh di atas akan memblokir semua URL yang mengandung query string parameter, sehingga bot tidak mengcrawl halaman dinamis dengan tanda tanya di akhir path.

Memakai Simbol Dollar

Simbol dollar ($) pada dasar robots.txt digunakan untuk menandai akhir dari pola URL yang dicocokkan. Contoh:

|

1 2 |

User-agent: * Disallow: *.html$ |

Simbol dollar di sini memastikan blokir hanya berlaku tepat pada file yang berakhiran .html, tanpa memengaruhi URL lain yang mengandung .html di tengah path.

Sintaksis Dasar Robots.txt

Setelah memahami aturan dasar dari dasar robots.txt, sekarang kita bisa mempelajari sintaksis yang terdapat di dalamnya. Sintaksis ini memungkinkan penggunaan setiap fungsi konfigurasi secara optimal untuk mengontrol crawling dengan lebih presisi.

Direktif User-agent

Direktif User-agent pada dasar robots.txt berfungsi untuk menentukan crawler mana yang akan terpengaruh oleh aturan berikutnya. Direktif ini biasanya menjadi awalan sebelum Disallow atau Allow diterapkan.

Contoh penggunaan:

|

1 2 3 4 5 |

User-agent: * Disallow: /wp-admin/ User-agent: GPTBot Disallow: / |

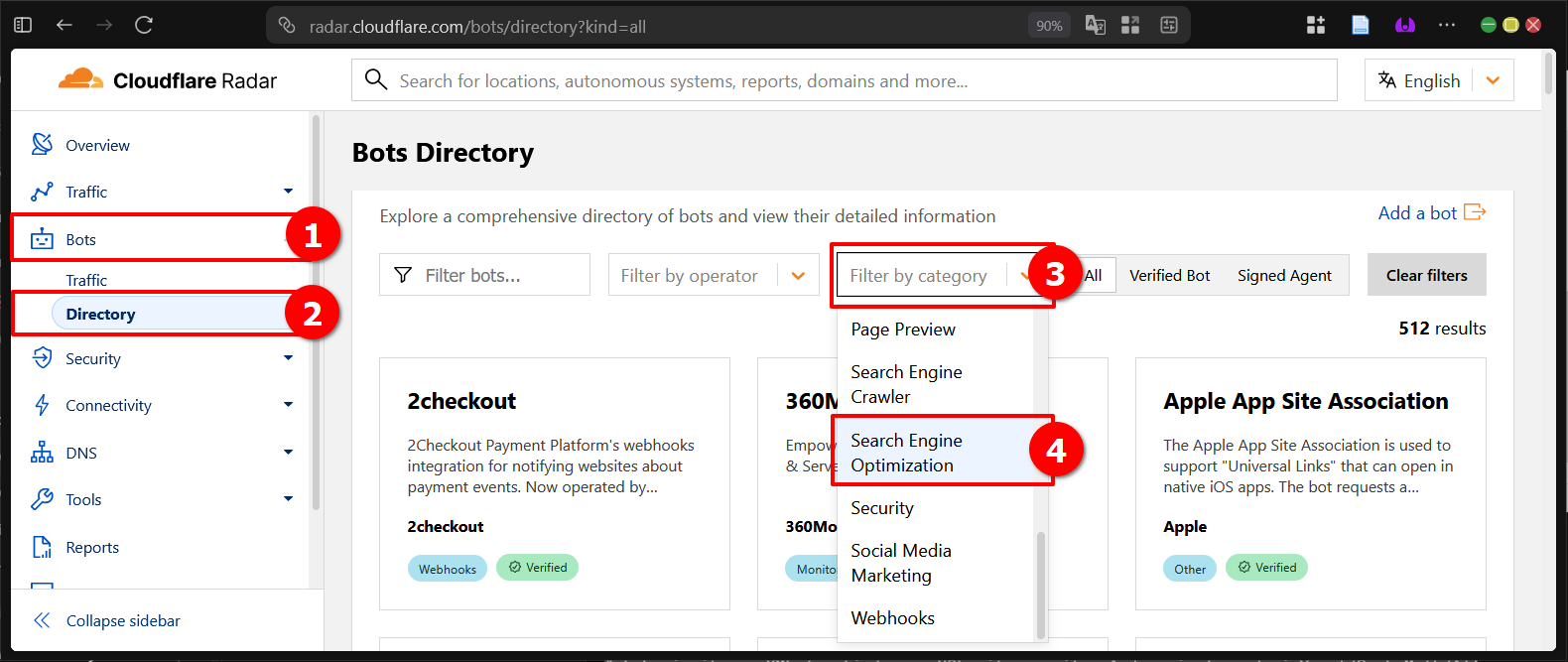

Pada format di atas, aturan pertama berlaku untuk semua bot (*) dengan memblokir folder wp-admin, sementara aturan kedua khusus memblokir seluruh situs untuk GPTBot. Untuk melihat daftar User-agent yang digunakan pada mesin pencari, kita bisa mengunjungi Cloudflare Radar di bagian directory bots.

Direktif Disallow dan Allow

Direktif Disallow berfungsi memblokir akses bot ke path tertentu, sementara Allow mengizinkan akses meskipun ada blokir lebih umum. Kedua direktif ini selalu digunakan setelah User-agent dan tidak bisa berdiri sendiri.

Contoh:

|

1 2 3 |

User-agent: * Allow: /media/terms-and-conditions.pdf Disallow: /media/ |

Cara kerja format di atas adalah mengizinkan akses khusus ke file PDF tertentu, tetapi memblokir seluruh folder media untuk semua bot, sehingga prioritas Allow lebih tinggi pada path spesifik.

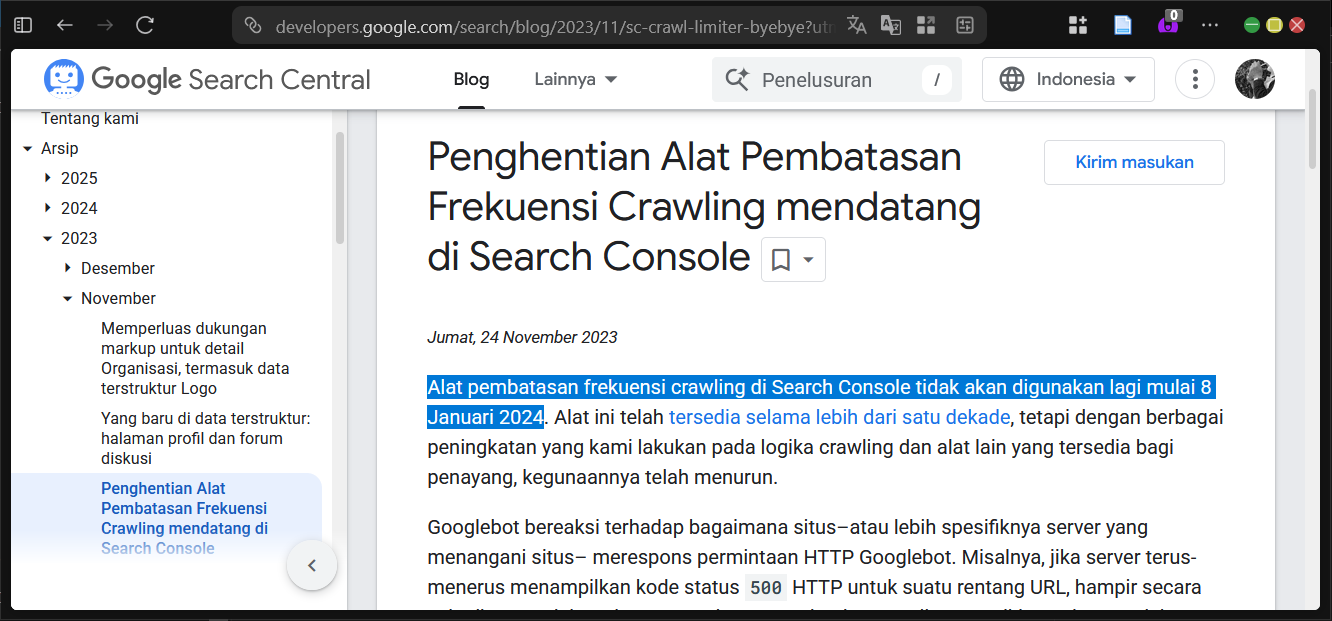

Direktif Crawl-delay

Direktif Crawl-delay pada dasar robots.txt dulunya digunakan untuk mengatur jeda waktu antar permintaan crawler dalam detik. Namun, sejak Google mengklarifikasi bahwa direktif ini tidak didukung lagi, serta beberapa mesin pencari lain mengabaikannya, tidak perlu ditambahkan pada konfigurasi baru.

Contoh penggunaan lama:

|

1 2 3 |

User-agent: BingBot Disallow: / Crawl-delay: 10 |

Format di atas seharusnya membuat BingBot menunggu 10 detik antar request, tetapi karena dukungan terbatas, lebih baik gunakan tools webmaster masing-masing search engine untuk mengatur crawl rate.

Direktif Sitemap

Direktif Sitemap pada dasar robots.txt berfungsi untuk memberi tahu lokasi file sitemap.xml kepada crawler. Penambahan ini bersifat opsional, terutama jika sitemap sudah disubmit ke search console, tetapi membantu discovery lebih cepat.

Contoh:

|

1 2 3 4 |

User-agent: * Disallow: /wp-admin/ Sitemap: https://www.contoh.com/sitemap1.xml Sitemap: https://www.contoh.com/sitemap2.xml |

Cara kerja format di atas adalah mengarahkan semua bot ke multiple sitemap sambil tetap memblokir wp-admin, sehingga crawling menjadi lebih terstruktur.

Direktif # atau komentar

Direktif # atau komentar pada dasar robots.txt digunakan untuk menambahkan catatan penjelasan tanpa memengaruhi aturan. Komentar bisa pada baris terpisah atau di akhir direktif.

Contoh:

|

1 2 3 |

# Semua robot tidak boleh akses ke- User-agent: * Disallow: /wp-admin/ # Tidak boleh akses, penting |

Cara kerja format di atas adalah mengabaikan teks setelah #, sehingga hanya aturan Disallow yang diproses oleh crawler.

Validasi dan Testing Robots.txt

Setelah kita memahami dasar robots.txt secara lengkap, langkah berikutnya adalah melakukan validasi untuk memastikan struktur berfungsi sesuai harapan. Validasi membantu mendeteksi error sebelum diterapkan di situs produksi.

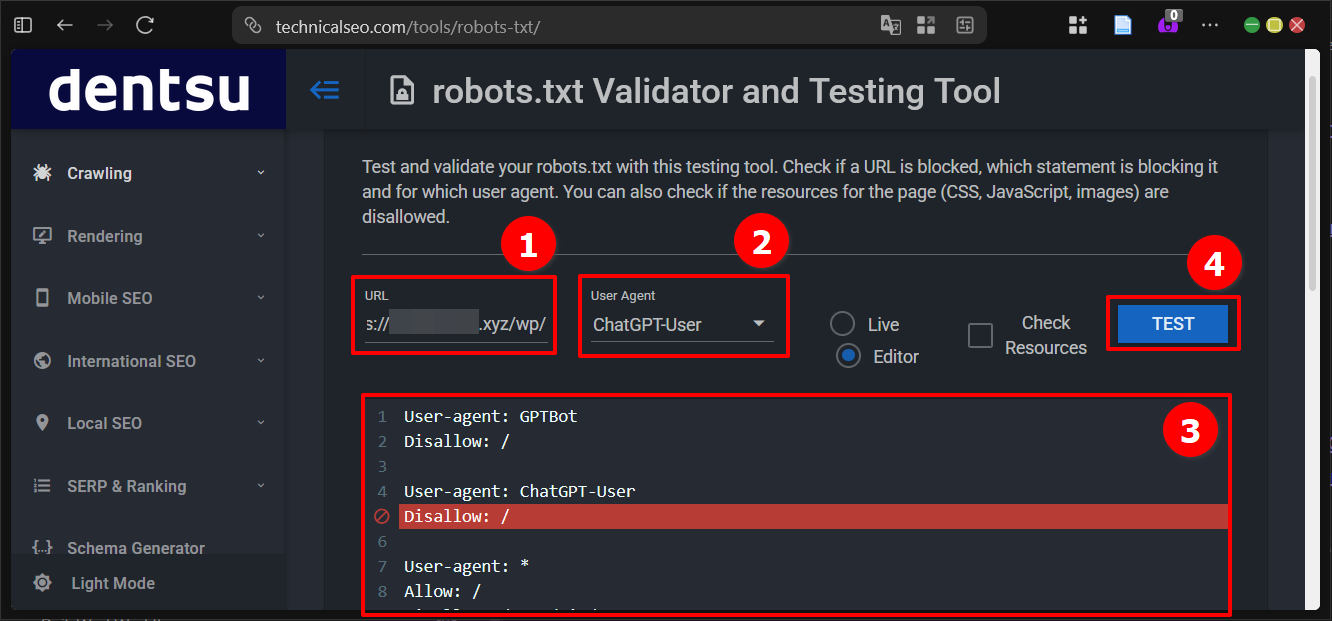

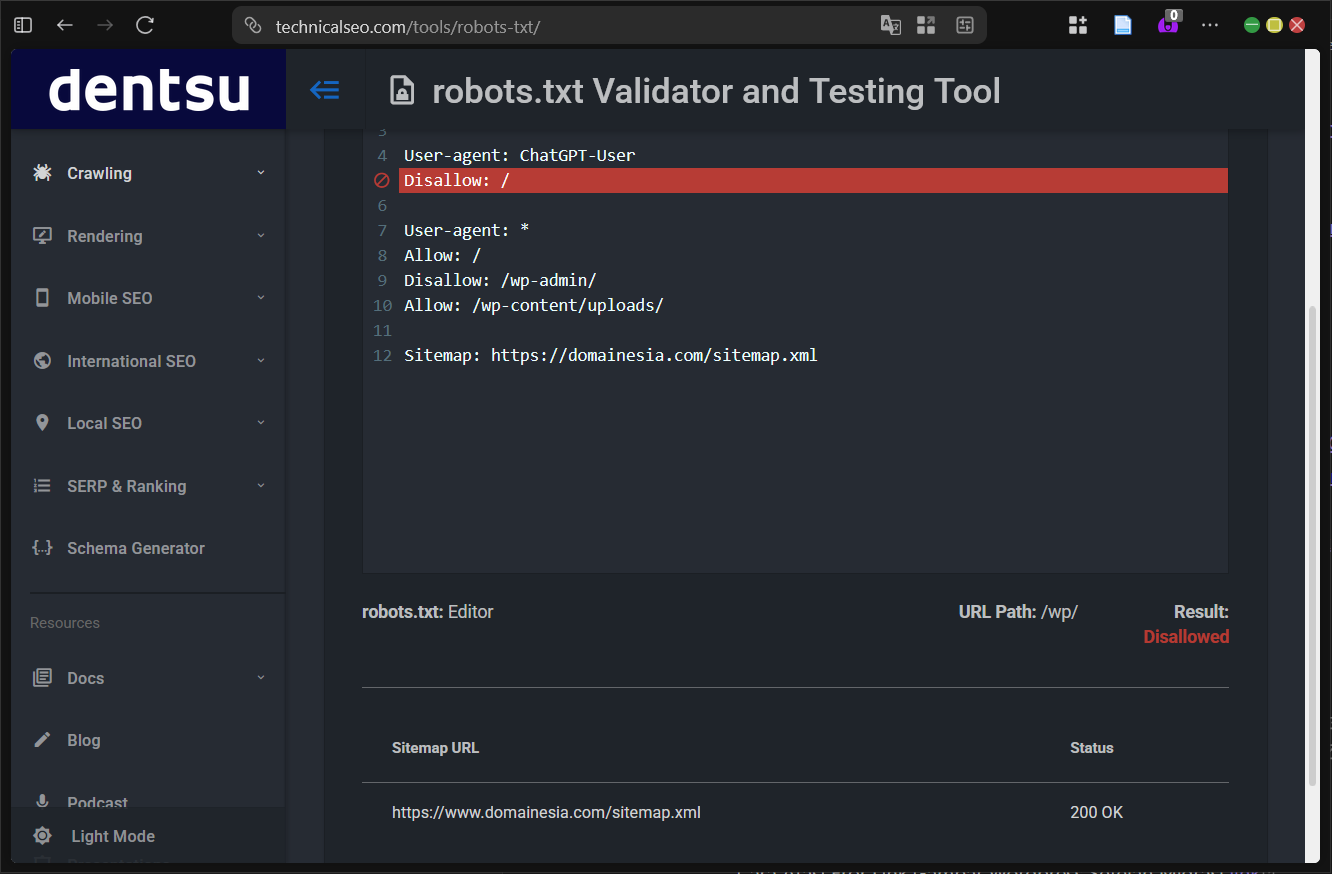

Kita bisa menggunakan tools validasi robots.txt online yang tersedia di https://technicalseo.com/tools/robots-txt/.

Pada tools tersebut, kita dapat langsung membuat atau paste struktur dasar robots.txt, kemudian menguji dengan memasukkan URL spesifik pada kolom yang disediakan untuk melihat apakah diblokir atau diizinkan.

Hasil pengujian akan tertera secara detail beserta penjelasan saat kita mengklik tombol Test, termasuk user-agent mana yang terpengaruh.

Setelah pengujian berhasil tanpa error, langkah selanjutnya adalah mengunggah file robots.txt ke root directory website melalui FTP atau file manager hosting.

Jadi Lebih Tahu Soal Robots.txt!

Selamat DomaiNesians!, kita sudah membahas tuntas panduan dasar robots.txt mulai dari pengenalan, struktur konfigurasi, aturan penting, hingga sintaksis lengkap beserta validasi. Dengan pemahaman ini, pengelolaan crawling situs menjadi lebih terkendali, performa server terjaga, dan SEO semakin optimal. Sampai jumpa di artikel dan panduan DomaiNesia berikutnya!